0%

全球 AI 發展已進入白熱化的軍備競賽階段,大型科技公司、雲端服務商,乃至於國家級機構為了不在此波落後,紛紛投入巨額算力資本支出,而是為了搶占未來十年 AI 所帶來的龐大潛在商機。即使 AI 商業化的明確路徑尚未完全浮現,但資本支出卻依然持續湧入,然僅有算力是不夠的,算力必須要有足夠的電力才能推動,因此,「能源(電)」就成為更底層更重要的核心戰略資源。

富果觀點:

-

隨著台積電投入大量資本支出進行擴廠,資料中心的基礎設施瓶頸已從過去的晶片短缺( GPU)漸漸轉變為電力供應不足。

-

美國的許多電廠設施相對老舊缺乏擴充性,且擴建時間長(平均 2-10 年),未來算力交付與電力擴張將產生錯配。

-

原握有大量電力資源的虛擬貨幣礦商,正轉型切入 AI 雲端服務領域,可望獲得新的成長動能。

GPU 供應緩解,電力供應成為下一個挑戰

在 2024 至 2025 年間,全球 AI 伺服器擴張的關鍵限制是 GPU 的產能不足。NVIDIA 的 AI GPU 幾乎一出貨就被搶購一空,資料中心擴建計畫常因無法取得足夠 GPU 而延宕,這時期的競爭焦點在於誰能搶到更多晶圓產能。隨著晶圓廠擴產、先進封裝產能提升與產品線調整,GPU 供應量已逐步緩解,但 AI 資料中心即將面對下一個挑戰 - 電力需求暴增與電網容量不足。

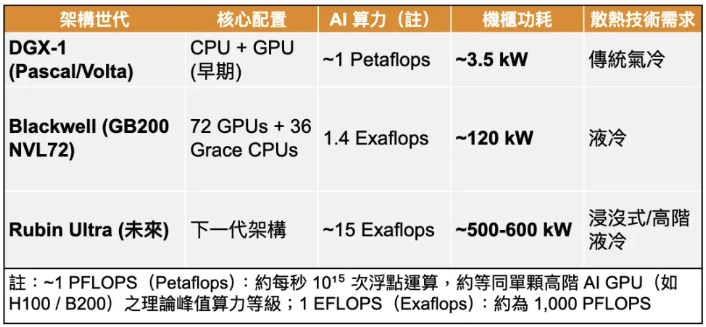

早期 AI 伺服器 (DGX-1),搭載 20 個 CPU 核心與 128 GB GPU 記憶體,算力為 1 Petaflops,瓦數約 3.5 kW。產品迭代至今,blackwell GB 系列,是一個完全液冷(liquid-cooled) 的系統。透過液冷技術,NVIDIA 將運算節點壓縮到一個機櫃中,擁有 1 Exaflops 的 AI 算力(1000 petaflops),機櫃瓦數達 120 kw,而下一代的 Rubin ultra 系列,每個機櫃將擁有15 Exaflops 的算力,機櫃能耗瓦數高達 600 kw,算力提升 15 倍,與之相應的是,電力需求也增加了 5 倍。

透過歷代架構對比可看出能耗增長速度驚人

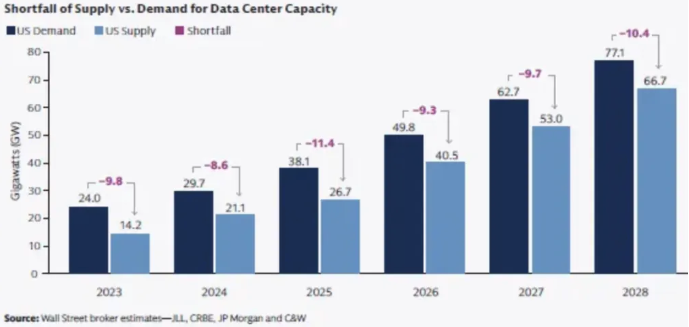

根據摩根士丹利的數據,美國未來幾年的 AI 電力缺口高達 46-47 GW,這規模相當於需要額外建設約當 8 個紐約市或 1.5 個台灣一年發電產能才能填補(註)。如今電力上限已成為 AI 算力的天花板,擁有穩定電力資源的企業成為這場競賽中真正的贏家。

註:假設全年用電量紐約市約 500 億度/台灣約 2,800 億度電推算

立即註冊會員閱讀全文10 秒註冊解鎖完整報告

10 秒註冊解鎖完整報告

每週更新,精準掌握投資決策

成為會員繼續閱讀全文,再享每週更新獨家研究報告與多項富果投資研究工具!

- 精選研究報告完整時事短評、法說會備忘錄

- 技術圖表多種投資分析工具與指標

- 筆記功能速記投資心得與重要筆記

- 自訂版面客製喜歡的看盤版面